|

/ ~: i. \' q4 c0 x8 G# C% _

原标题:声声声声临其境,一起坠入阿里云超音感空间 & I& L4 y$ h. s2 v2 O

2 b2 ?: d6 Y+ B; M

% z( U7 \* D9 I; t& n0 F

. e1 s' b4 n- C 大众对沉浸体验的追求,不再仅局限于“视觉”。声之切,境尤升。

K/ m+ Z% L' ]& p( o1 l F( a3 G" f& L6 x+ a) Q. g: k

$ P& ]9 q3 K" ?! L$ W3 ~2 X# c9 X# s 随着硬件技术的升级、软件内容的丰富以及5G网络环境的优化,推动几经浮沉的VR产业走向正循环。

9 J$ d. ] g( B: }0 ], S( }3 m 就在去年,「Roblox上市」、「Facebook更名为Meta」、「微软收购暴雪」等将元宇宙相关产业推向风口,而Oculus Quest 2(VR一体机)出货量破千万台的成绩,更是一件将沉浸式VR从概念落地场景实践的标志性事件。

) [9 c5 ?7 X# [5 p2 U1 O v& F6 W! C 在本次云栖大会阿里云视频云的8K VR视频技术展台,体验者通过佩戴Pico VR头显,感受清晰度高达8K的360度VR视频,实时捕捉超高清细节。

- ?% B7 H; }/ f7 f! r% b 不仅如此,体验者还能以“声”临其境,感受令人惊艳的全景声技术带来的沉浸式视听体验。

/ [3 a" G$ b3 A7 B% l' o4 h2 {

5 A0 m1 @1 E: ^+ \

" W8 x) T6 q8 W% a 01“视”之外的沉浸之“声”. \. J+ A. [" \7 K C% d

「沉浸式视听体验」一词已多次出现在大众视野,究竟什么是沉浸式视听体验呢? 7 p1 r& }$ A# t

“沉浸式视听体验”是指通过视频、音频及特效系统,构建大视角、高画质、三维声特性,从而具备画面包围和声音环绕的主观感受特征,观众在所处位置就能获得周围多方位的视觉、听觉信息,带来身临其境之感。 0 Q: [/ K% }5 K( D9 Q( A0 i

听觉作为仅次于视觉的重要感官通道,对沉浸式的视听体验至关重要。随着用户对视听体验的极致追求,在“视”之外,沉浸之“声”技术应运而生。 5 c5 e+ d# E) |; E/ L

「沉浸式音频」是指能够呈现空间的还音系统的声辐射,至少能覆盖观众的前、后、左、右、上五个方位。除此之外,还能真实地营造出声场的水平纵深和垂直高度,即从听者角度能精准地定位声音的方向和位置。

9 F' ~7 R; L5 p; P( g 从技术角度是如何实现呢?

6 O" y) H- C' U8 l6 q0 \ 其实,真实世界的声音来自环境的四面八方,人耳往往可以通过声波的时间差、强度差、相位差、频率差等辨别声音的方位。 % z; O2 J8 i- J' y# E

但现有的立体声和5.1环绕声只能呈现部分方向传来的声音信息,若想获得声音带来的沉浸感,需要尽可能全方位再现真实世界的声音,也需要一种沉浸式音频技术来实现。

6 }. [* H3 P1 i9 w* N. H  图片来源于网络 图片来源于网络

: L T8 A0 v I K& Z, x; |

02一个「球面」的声场?

4 o4 k# D3 I) N5 A- S- R 沉浸式音频主要技术有三大类: 基于声道 Channel Based Audio(CBA)、基于对象Object Based Audio (OBA)、基于场景 Scene Based Audio(SBA)。 : I9 j0 n) k9 h c. h8 E, e

❖ 基于声道技术(CBA):在传统 5.1 环绕声的基础上,增加了 4 个顶部声道,通过增加声道的方式来补充空间中的声音信息,但只能呈现部分方向来的声音信息。

2 \ j" n7 ^0 Q$ g ❖ 基于对象的技术(OBA):是目前主流技术,并在电影领域已广泛应用,如 Dolby Atmos 全景声。该技术会产生大量的数据和运算,除了声道的音频外,还有关于声源的元数据Metadata,即:声源(位置/大小/速度/形状等属性)、声源所在的环境(混响Reverb/回声Reflection/衰减Attenuate/几何形态等),该技术在VR领域只适合主机VR上的大型游戏,对于普通移动端的硬件设备来讲,算力及带宽承载具有较大压力。

* d9 T6 c. @6 A; t, h7 |8 L ❖ 基于场景的技术(SBA):用来描述场景的声场,其核心的底层算法是Ambisonics 技术,可被映射到任意扬声器布局中。Ambisonics技术的特点是:声源贴在提前渲染好的全景球上,即所有声源将被压缩在了这个球上。 + s, x# F" s m

图片来源于网络 图片来源于网络

2 M' R% z% X6 e' E( E$ V

本文的音频体验展示便采用了Ambisonics的录制格式(文末体验DEMO)。 6 B* E9 R4 K, ^% k

Ambisonics作为全景声的一种录取格式,在上世纪70年代就已经问世,但一直没有获得商业上的成功。 8 u! Y' m( j( P& z5 F1 Y

随着近几年VR,AR等相关领域的兴起,Ambisonics开始逐渐被讨论。与其它多声道环绕声格式不同,Ambisonics传输通道不带扬声器信号,允许音频工作者根据声源方向而不是扬声器的位置来思考设计,并且为听众提供了用于播放扬声器的布局和数量,因此,大大增加了灵活性。

7 t! o2 `3 K, f7 ^5 V, b% a Ambisonics音频格式可以解码任何扬声器阵列,并且可以完整地、不间断地还原音源而不受任何特定编解码播放系统的限制。 / k: T8 B2 n) t

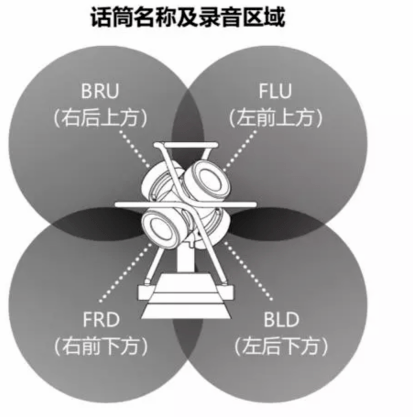

下图是一个一阶的Ambisonics结构,4个MIC垂直部署在一个四面体上,播放效果与Dolby Atmos类似,但和Dolby Atmos不同的地方是:Dolby Atmos 只解决了半球的声场。

/ u1 _, u8 i# ^- g% G 而Ambisonics除了水平环绕声音,还可以支持拾音位置或者听众上下的声源,即整个球面的声场。 - b/ p+ x( {4 J- T1 C4 w" D

: p2 ]0 V0 z3 a! S& L- W& f- U  图片来源于网络 图片来源于网络

$ K( P1 h6 g& b: i 03实现声声入耳的引擎:AliBiAudio5 s/ L- N6 l$ M+ T# P t7 @1 i

全景声不仅仅是增加几个声道那么简单,而是把整个声音系统架构都颠覆了,从之前基于声道来混音的技术上升为基于对象的音频处理技术,使人在环境中的听觉感受与现场实际声音一致。

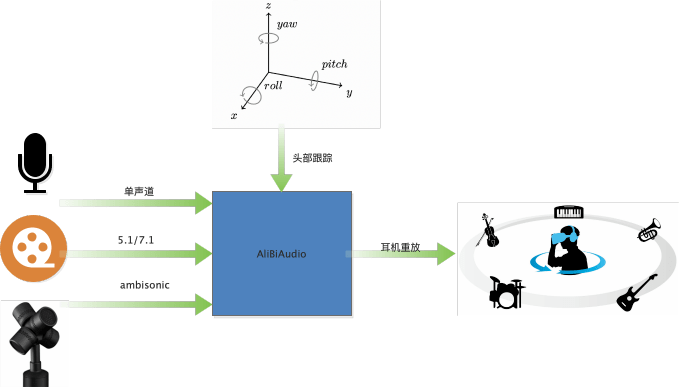

1 E) |% F4 ~$ g2 ? 将全景声音频重建成用户可测听的形式有两种途径,一种是多扬声器重建,即电影院或家庭影院中的音响系统,其本质是将全景声音频转换到5.1.4或7.1.4格式;另一种是耳机重建,即将全景声音频通过双耳渲染技术转换为双声道音频,并保留其全部空间信息。 * D7 V% x3 d2 m& B

相对于多扬声器重建,耳机重建成本低、易部署、效果好。 ! f0 q9 @9 ]* o M& O4 ]2 o

不言而喻,耳机重建全景声音频,需要一个双耳渲染的过程,以此来通过两个立体声通道创建空间和维度的听觉感知效果。

% a }! E% {/ Z, }! i7 K8 r$ g

# G E$ P3 H; H4 I

AliBiAudio 就是一个阿里自研的双耳实时渲染引擎,结合头部跟踪坐标,可以达到人转动,声源位置不动的效果。当前双耳渲染引擎,具有支持全平台、多场景、易部署等特性。该引擎既可以部署在移动端,也可以部署在云端,并支持三大场景的渲染。 9 C4 Z+ u& T! d: M# M1 ^* {' Z

❖ 单声道输入:用于虚拟会议场景,可将不同位置的人,渲染在不同的角度发声,通常部署在服务端。 $ W6 L) ]: e1 i% g* P

❖ 5.1/7.1 输入:用于影视剧渲染,得到更逼真的环绕声,类似优酷中的“帧享”音效。既可以部署在端上(如:Apple Music 空间音频),也可以部署在服务器上(如:作为媒体处理,将多声道数据下混成2路数据)。 ! n) A: o2 G) b! u9 H z

❖ Ambisonics输入:对Ambisonics格式进行渲染,用于VR直播,VR点播,当前部署在Aliplay中。

; \1 D: J/ k: L- C! n* z/ E+ j+ ^

" w% C$ _0 I, [( o. \' T

04如何让声音跟随脑袋一起摇摆

& A" }# r# `0 t2 P2 q+ `! n* Q ❖ HRTF

1 C( `2 z9 s3 {- R 双耳渲染引擎的核心模块是人头传递函数HRTF( Head-related Transfer Function )。

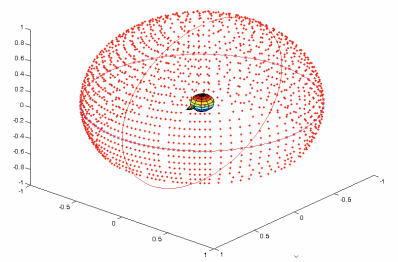

' g0 T/ X @9 p7 z 每一方向都有两个HRTF,分别代表音源到左右耳的房间冲击响应,通过720度扫描可以得到一个球形的HRTF库,如下图是一个ARI HRTF 数据库的分布。

* Z) r3 L8 `1 i5 g* l6 S* E! G

% B# s9 q+ [) @ ARI HRTF 数据库

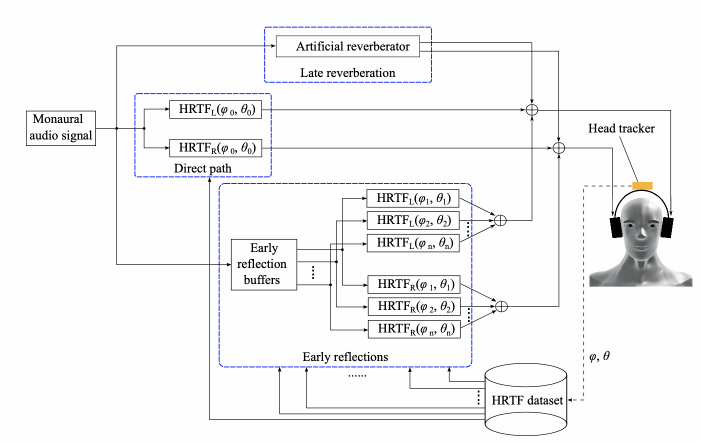

: h0 Z' `5 g0 R4 m% V# { 在渲染时,通过输入的角度信息,先从数据库中选出当前角度的HRTF对。然后再将输入数据分别和HRTF对进行卷积得到左右耳信号。为了得到更逼真效果,还可以添加一定量的房间混响如下图所示:

4 W- n& @: G+ N, C3 l4 Q+ x

5 _. b) A/ g5 Y. r4 }1 W 本项目对大量HRTF库进行筛选,获取到一个最优的数据库。 ) f- d2 j- {. U: ~

❖ Ambisonics数据格式 ! e3 Y) Y4 c: K

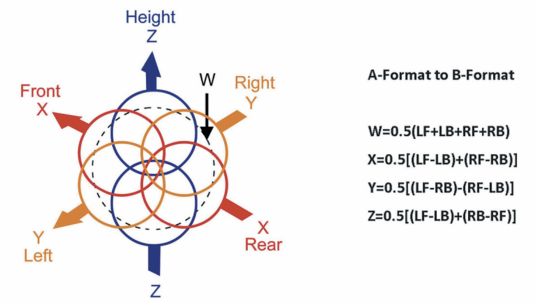

Ambisonics 的基础功能是让来自不同方向点声源,作为360度的球面来处理,这个中心点,就是麦克风放的位置。当前广泛用于VR 和 360 度全景视频的Ambisonics 格式,是一个叫做Ambisonics B-format的4声道(还有另一种格式叫A-format)。由W, X, Y and Z组成。对应着360度球面的,中心,左右,前后,上下。

0 B1 h& \7 t( J% n7 S; i+ J8 \/ b6 L

/ l' O# Y( e' f# t7 E W 是一个全向: T P. V& [9 G Y

X 是一个双极 8 字指向,代表前后) ]; H% {3 s! `4 V1 p

Y 是一个双极 8 字指向,代表左右9 S, A7 }7 e8 |6 I/ o9 T! Y- K$ S

Z 是一个双极 8 字指向,代表上下! E( l9 ~9 Y' n2 h' i

! A0 h4 x( z, M. w, H5 {) R

B-format 有两种格式分别是ambix 和fuma(它们只是排列顺序不同),而A-format 代表4个mic 采集的原始数据。B-format和A-format的关系如下: 4 S \ z* e. b8 B7 F; J

图片来源于网络 图片来源于网络

6 n" R! B4 ]: Y2 A7 e

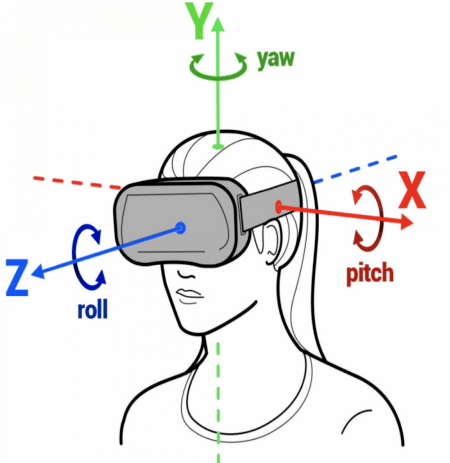

❖ 头部跟踪 7 M' ^: I5 z) o/ C9 T! F0 M

该技术利用了某些特定款式耳机中的传感器信息,如:加速度计和陀螺仪,从而更好地跟踪头部运动,并做出相应的音频调整。 " X3 e& z) U9 I! h' ]( J6 P

Apple已经从 iOS 15 开始通过兼容耳机带来支持头部跟踪的空间音频功能,目前Android 13的发布预览版已完全支持在兼容设备上使用头部跟踪的空间音频。本次云栖大会的展台体验便主要利用了Pico头显设备中陀螺仪的信息。 1 z2 z/ ]( Z$ I9 d; F( k

图片来源于网络 图片来源于网络

% w8 ?+ R+ z9 Z9 s0 M- x* |

05一起「声」临其境

% T2 q0 R; Q& r; y. G: l 「佩戴耳机」体验全景声,效果更好哦! % V7 x+ V* Y# k; C5 l

现场体验中,声音的变化会随着头部的转动而转动,本次线上DEMO体验将依靠手动界面移动来模拟头部转动。 # u' D6 w, s. O0 y' h! t

01听:无人机掠过头顶

# s6 Z6 e, {( m9 c) \% @' ?; p$ M( X; J0 |2 G% J! [

无人机逐渐升起从头顶掠过,当视角跟随(模拟)无人机时,声音相应地实时变化。 % }8 O1 y( D2 ^5 q

02听:滴答滴答 # @8 w% B/ |' c7 _: p

: l( r& V" G+ i& X& V K, N 聆听水滴的同时,发现左方有无人机的声音,视角随声而转,一路跟随,感受无人机由近及远的变化。 , T! E9 @4 E+ _* n" O6 |

03听:沉浸游园

# [7 w: @% n- k8 f) n3 ~* G" R8 q/ M9 W: l6 ~

主持人在介绍园区时,用户向四周左右观看(模拟),在此过程中,主持人的声音呈现与他在你视角的位置始终保持对应。

9 d7 G8 p+ w7 Q% _+ ]* w/ y8 u 04听:PING PANG之声 8 U2 e4 l- N' p! ]. K8 g" V

% c5 \, K1 q" V5 B. @' ^! B+ s$ E

沉浸式场景怎能少了运动!一转头,乒乓之声已被“抛之脑后”。 % _( e. s% S0 R4 j: a2 R! v

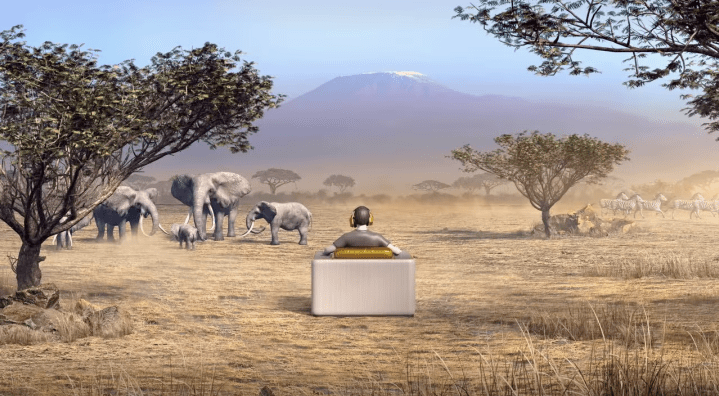

06音频的未来,炫到无法想象

! o8 d1 U8 T/ W. i2 U' b 除此之外,全景声双耳渲染技术还可运用于多个场景,带来沉浸视听的无限想象力。

! e# A' d% {* B# u k! _ k2 U ❖ VR演唱会 - K0 p. N$ d K* P( N* h( [

现场混合360度视频和全景声音频, 同时将数据传输到相应的移动平台,并进行实时直播。让观众可以达到“不在现场,胜似现场”的感觉。

s Q. p$ A9 T, w7 {6 T0 r& B" \0 l- o

❖ 沉浸式影院

2 r2 Q4 w6 Y q s" o7 ~ 也可以称之为沉浸式投影,是一种成熟的高度沉浸式虚拟现实系统。它将高分辨率的立体投影技术、三维计算机图形技术和音响技术等有机地结合在一起,产生一个完全沉浸式的虚拟环境,大大增加观影的沉浸感。

; v# ^1 @; ?" d& U( Z3 Y" j5 q ❖ 智慧教育

7 K$ v- W# g1 Q2 O 沉浸式教学模式逐渐受到教育界的关注。例如,IBM研究院和伦斯勒理工学院联合开发的“认知沉浸室 ”,它能让学生置身于中国的餐馆、商场、园林等虚拟场景,与AI机器人练习汉语对话,大大提升了学生的学习兴趣和专注力。

. U/ w' A) t: ^ ❖ 虚拟会议

0 i- g- l* R, i0 G% I& y6 y 以Facebook基于VR开发的虚拟会议为例。而为了更贴近现实,Workrooms还加入了沉浸音频功能,让用户交谈时,声音的发出的方向跟他们所处的房间位置一致,从而进一步增加参会者的沉浸感。

) e2 B6 f9 r+ b5 ^& Z/ |; Y6 t 图片来源于网络 1 ]3 w/ l4 i3 a! p( b

未来的沉浸音频技术将如何发展?

; J& q# h. g6 L5 M1 ^ 以双耳渲染引擎的核心模块HRTF为例来说,当前的HRTF模型,是一个固定模型,无法适应不同人的声音感知差异,尤其在正前方的外化能力还不够好。若想得到更逼真的声音效果,需对HRTF进行进一步优化,使其适应每个人的个体差异性。 $ V/ U$ i+ R) m0 ~ K

比如:根据每个人的人头大小,耳廓信息以及肩膀的形状独立建模。在国外HRTF的建模与个性化发展已经成为趋势:

! g% [3 o) J- t& F% \. V; N0 ~ 3月开始,杜比支持个性化HRTF的定制。

2 O4 }8 R* L% t0 N* t8 P6 l 图片来源于网络 $ g2 G0 q- Z9 \0 E

9月开始,iPhone升级了ios16,通过人脸扫描,可以定制自己的HRTF。 + t7 F# U8 V `+ F- d3 A/ N! ]

图片来源于网络

" s1 I6 b/ B; P0 h 此外,用机器学习的方法,将面部,耳部图片,转化成HRTF也在火热研究中。

X. l: H5 i& c8 w* Q) A 未来,阿里云视频云将继续探索基于深度学习与信号处理的的音频技术,为VR超高清视频直播带来以「声」临其境的超沉浸之感。

3 k& \% _; X# Y" \" } 参考文献: * Q/ E9 Z' c4 z& l/ z6 E

[1] 5G 高新视频—沉浸式视频技术白皮书 j( U0 w! s8 N* j5 x/ E

[2] https://m.fx361.com/news/2018/0326/3298705.html 3 k7 E/ `$ m2 ?2 r/ u3 Y

[3] https://3g.163.com/dy/article/ELBCI2OG053290QL.html?clickfrom=subscribe / [, ?/ R) z( X. n

[4] https://www.birtv.com/Magazine/content/?246.html : P r8 j7 x% E$ `7 e

[5] https://m.midifan.com/article_body.php?id=6201 * @# R, g9 z* ]+ `4 T( c

[6] https://sound.media.mit.edu/resources/KEMAR.html 3 C8 h% x+ G% G0 f7 N9 c7 F

[7] https://juiwang.com/assets/projects/hrtf_nn_bem/hrtf_nn_bem.pdf

* C2 G9 }- y$ d$ \ [8] https://www.tvoao.com/a/208656.aspx返回搜狐,查看更多 $ V6 l4 ^7 }' G" q2 Y1 T& G

$ y8 ]3 e8 i `8 Q: G; f

责任编辑: X8 V4 f/ l9 `

% a+ |, j- \' F1 ]: ~+ a9 o' a8 `6 I8 ] x Z8 y" [3 C4 F

! \8 |% h* X4 T! l) v" J/ S

1 e) k8 N* s& Z& P. ~

|